刘清堂,苗恩慧,常瑀倍

华中师范大学

电邮:liuqtang@mail.ccnu.edu.cn;1109584833@qq.com; changyb@mails.ccnu.edu.cn

【摘要】人类的情感状态对于认知过程具有调节作用,能够影响学习效果,对于学生情感的分析具有重要意义,目前基于多模态数据的情感状态分析引起了广泛关注。多模态情感分析的发展动因主要有外在技术推动、内在机理探索驱动和自身独特优势加持三个方面,实施路径主要包括数据采集与处理、多模态数据融合、情感识别与反馈三个主要步骤,常用的数据包括文本、音频、图像和生理数据。未来多模态情感分析的发展可以探索更多教育场景中的应用、探索多模态数据的最佳组合方式、优化情感分析模型和系统以及纳入更多情感状态。

【关键词】多模态、情感分析、多模态情感分析、学习分析

Abstract: The emotional state of human beings plays a regulatory role in the cognitive process and can affect the learning effect. It is of great significance for the analysis of students' emotions. At present, multimodal sentiment analysis has attracted wide attention. The development motivation of multimodal sentiment analysis is mainly driven by external technology, internal mechanism exploration and its own unique advantages. The implementation path mainly includes three main steps: data acquisition and processing, multimodal data fusion, emotion recognition and feedback. The commonly used data includes text, audio, image and physiological data. The future development of multimodal sentiment analysis can explore more applications in educational scenarios, explore the best combination of multimodal data, optimize the sentiment analysis model and system, and incorporate more emotional states.

Keywords: Multimodal, Sentiment Analysis, Multimodal Sentiment Analysis, Learning Analysis

1.引言

人类情感状态能够对注意、记忆等认知过程起到调节作用,与认知加工过程联系紧密,可以显著影响学习者的学习效果(Wu, Huang, & Hwang, 2016)。学习者的情绪状态已被证明是成功学习的关键因素,真实课堂环境中的心理和情感监测在帮助教师理解和支持学生学习的同时,也能帮助研究者理解学习发生的原理和过程(吴永和、李若晨和王浩楠,2017)。情感是全面感知和分析学习过程时不可忽视的重要因素(周进、叶俊民和李超,2021)。情感分析关注学习者在学习过程中的情感状态与变化情况,能够为智能化教学活动的开展提供支持,对于促进学习者的学习效果具有重要意义(黄涛、王一岩、张浩和杨华利,2020)。

随着传感技术与人工智能的融合应用,通过采集多模态数据来客观挖掘学习情感已成为教育研究的发展方向,学习过程中的生理数据(包括脑电、皮肤电、肌电、心率、血氧等)为多模态情感分析提供了多维度的数据(周进、叶俊民和李超,2021)。多模态情感分析融合不同模态的信息来解释和挖掘学生心理特征,与专家分析、心理量表、自报告等其他传统方式相结合,能够从客观的多维度数据更加真实全面地展现学生的情感状态,在真实反映学生情感状态、助力学生学习方面具有巨大潜力。

2.多模态情感分析的发展及其动因

2.1. 情感分析

情感分析是分析人们对于产品、服务、组织、个人、事件、主题及其属性等实体对象所怀有的意见、情感、评价、看法和态度等主观感受的研究领域(Liu, 2012)。情感分析的主要目标是识别和测量人们的外显情感表现,并将其与人的内隐情感联系起来。情感状态的识别有助于分析用户的反应,从而探究背后的行为意图并进行合理的反馈(Yadegaridehkordi et al., 2019)。

教育领域的情感分析研究起始于20世纪30年代,最初主要关注的研究对象是考试焦虑,早期形成了新行为主义理论、认知-注意模型等试图解释考试焦虑的认知理论(Reis et al., 2019)。20世纪90年代以后,情绪在认知和动机中的作用引起了教育领域的关注,研究人员拓展了研究领域,从不同角度探究情绪与学习的关联,并产生了一系列的相关理论,如:自我调节学习理论、技术接受模型等。来自不同领域(如教育、心理学、神经科学等)的研究人员已经讨论了情绪与认知过程的相关性。皮亚杰提出情感方面强烈影响认知过程;Izard认为积极情绪能提高学生的学习成绩,而消极情绪则有相反的作用;维果茨基认为智力和情感元素与学习具有紧密关系(Reis et al., 2019)。随着研究人员对情感领域的关注,相关研究成果也愈加丰富。21世纪以来,随着智能技术和脑科学的发展,情感分析引起各领域的广泛关注,研究者在原有理论基础上进行了扩充,形成了多媒体学习的认知情感理论与成就动机的控制-价值理论等经典理论(周进、叶俊民和李超,2021)。

在教育领域,传统的情绪分析主要基于文本信息进行,大多研究使用自报告法、问卷调查法或专家观察法进行研究,其中常用的量表有成就情绪问卷(Achievement Emotions Questionnaire)、自我评定量表(Self-Assessment Manikin)等。文本情感分析的优点是简单和成本低,但也存在非实时、准确度低等问题。在自然语言处理领域,文本情感分析主要基于情感字典和机器学习两种方式进行。基于情感字典的方法是使用人工或半人工构建的情感字典,根据文本语句中的情感词来计算文本的情感分数以获得情感倾向(林敏鸿和蒙祖强,2020)。基于机器学习的情感识别方法是利用训练好的分类器对待分析评论进行情感倾向性识别(朱琳琳和徐健,2017)。

基于文本的情感分析无法对非文本模态的数据进行情感分析,但图片承载着许多能够反映用户情感的信息,随着技术的不断发展,研究者在文本情感分析的基础上探究了图像情感分析,目前已逐渐发展成熟。图像情感语义的抽取,大致经历了基于图像视觉特征的情感语义提取和机器学习两个发展阶段(汤丽萍和陈芬,2018)。目前应用较多的是基于机器学习方法抽取图像情感语义的特征,典型的算法模型有深度信念网络(DBN)、深度残差网络(DRN)和卷积神经网络(CNN)等(李志义、许洪凯和段斌,2019)。随着传感器技术和可穿戴技术等的发展,通过传感器等设备采集多通道数据,利用机器学习算法处理多模态数据,识别与反馈情感状态的多模态情感分析已成为研究者关注的新兴领域。

2.2. 多模态情感分析

随着教育神经科学、脑认知、学习科学、传感技术以及终端技术的发展,基于多维度的生物数据考量学习行为及心理特征已成为教育技术研究的趋势(张琪和武法提,2016)。学习是一个复杂的过程,使用单一的数据流难以完整地理解学习的发生过程,多模态数据在理解学习者的认知、情绪、注意力等方面具有巨大的潜力(Giannakos et al., 2019)。多模态数据涵盖文本、音频、视频、生理信息等多种数据类型,能够提供关于学习过程的不同维度和不同时间尺度的信息,从多个维度全面、精准地记录真实的课堂情景,从这些数据流中可以推断出包括情感、注意力、认知加工、压力和疲劳在内的一系列更高层次的特征,对于理解学生认知情感状态、预测学习效果等具有重要意义(Olsen et al., 2020)。教育研究人员已经探索了广泛的多模态数据源,以及如何使用它们来洞察不同学习场景的认知、元认知和情感维度(Lane, & D'Mello, 2019)。

多模态情感分析是指对包含情感信息的图像、视频、语音、文字等多模态数据进行情感分析的过程(Huddar, Sannakki, & Rajpurohit, 2019)。其任务是基于语言、视觉和听觉等多种模态输入信息来预测用户所表达的情感倾向或情绪。人类自然表达情感和感受的方式通常是文本、音频和视觉模式的多模态组合(Poria et al., 2017),通过各种途径收集的大量信息可以研究者帮助识别学习者隐藏的情绪,更加全面地理解真实环境中的学习者行为(D'Mello, & Kory, 2012)。当前,多模态情感分析涉及心理行为和生理层面,涵盖文本、语音、面部表情、身体姿态、生理信息等数据维度,通过采用多模态数据融合算法,将多通道信息融合实现对学习情感的识别,在此基础上进行情感反馈与学习干预(周进、叶俊民和李超,2021)。

2.3. 多模态情感分析发展动因

从外在因素来看,一方面,各类可穿戴设备、传感器技术、物联网技术等的发展为多模态数据的采集、记录提供了外在技术条件,让收集高频、细粒度、全样本的多层次、多模态学习数据成为可能(汪维富和毛美娟,2021),另一方面,深度学习算法的发展也使得多模态数据的融合成为可能。从内在因素来看,教育领域对于学习机理的深入探究和学生情感状态的关注成为推动多模态情感分析发展的内生动力,研究人员尝试从多模态数据全面分析学习者的情感状态,进而理解学习如何发生以及如何有效促进学习。从其自身来看,多模态情感分析具有自身的独特优势,与以往的单一模态数据不同,多模态数据能够克服单个数据流的局限,将物理学习活动、身体运动、生理数据与数字化日志、自我报告数据结合起来,获取更为接近学习者与群体真实表现的细颗粒数据,使研究人员能够洞察学习者或学习群体每分每秒的发展,对复杂的认知、行为、情绪、动机等进行更全面的评估,更加全面地反映学习者的认知和情感状态(汪维富和毛美娟,2021),符合目前研究人员的需要。

3.多模态情感分析实施路径

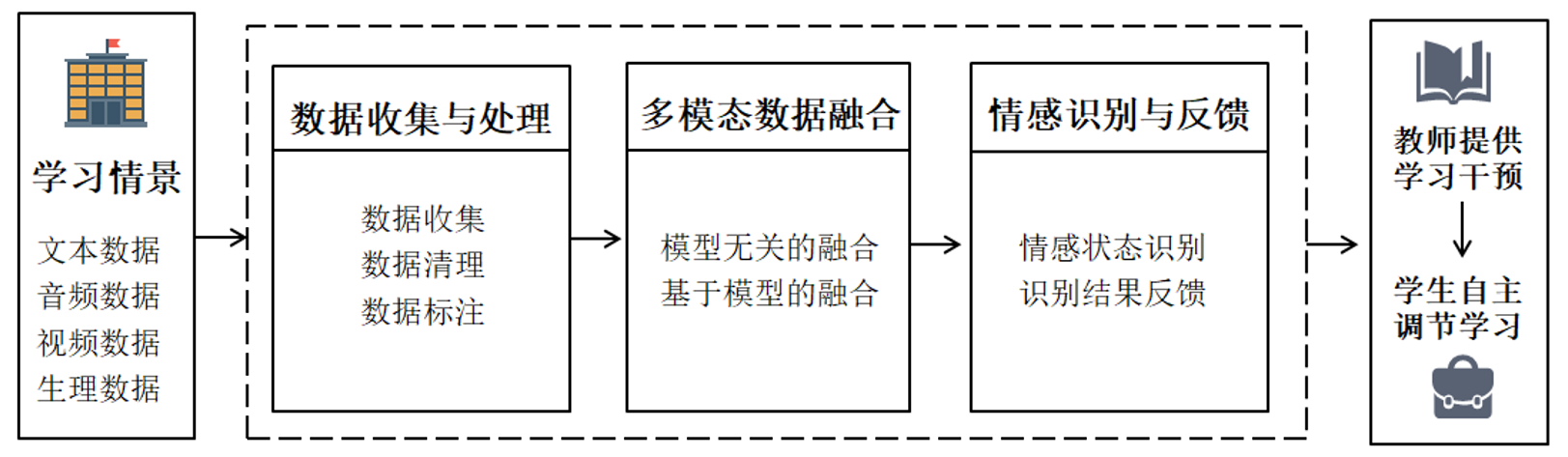

对多模态情感分析过程的梳理能够帮助研究人员对具体过程进行理解,进而开展后续规范的操作流程。从现有的多模态学习分析模型来看,目前的模型都包括数据发现、数据融合、数据利用三个关键步骤(汪维富和毛美娟,2021),结合情感分析的过程特征,多模态情感分析的实施路径可以分为数据收集与处理、多模态数据融合、情感状态识别与反馈三个主要环节(见图1)。

图1 多模态情感分析实施路径图

3.1. 数据收集与处理

学习数据的采集与分析是多模态情感分析的基础与关键,对于揭示复杂环境下的学习行为和学习规律有直接影响作用(牟智佳,2020)。多模态情感分析涉及的数据主要有文本、音频、图像和生理层面。文本数据主要从论坛、社交平台、测验、学生自我报告等途径获取,并利用情感分析方法挖掘潜在的观点与情感倾向(周进、叶俊民和王志峰等,2020);音频数据能展现教学情境下学生自然流畅的内容表达,主要通过分析音调、音色、语速、上下文信息等特征来获取情感信息;图像识别技术应用于面部表情、身体姿态、手势等维度分析,是多模态分析中常用的方法,其数据来源是利用摄像头采集学习过程数据;生理数据主要来源于心脏、大脑、眼动和皮肤,借助传感器设备采集心率、脑电、皮肤电等信息,获取身体受到生理刺激时的情绪反应(Olsen et al., 2020)。

多模态数据的采集以学习者及其所在情景为中心,对所关联及其影响的数据进行搜集分析,利用传感器对学习者行为及其环境数据进行采集,并转换为多种形式的数据流(牟智佳,2020)。在这个阶段需要通过平台、工具与传感器,从学习情境中收集多种模态的数据,如身体姿态、脑电信号、讨论文本、行为日志等,并对数据集进行人工注释(汪维富和毛美娟,2021)。之后需要对不同的数据集进行清理和结构化工作,删除无效数据,对数据进行转化、结构化和汇总,从中选取关键特征,为后续的数据融合做准备。

3.2. 多模态数据融合

多模态数据融合,主要是指利用计算机进行多模态数据的综合处理,负责融合各个模态的信息来执行目标预测(韩崇昭、朱洪艳和段战胜,2010)。数据融合旨在根据关键特征来集成两个及以上的数据集,生成基于多模态数据的连贯性、对齐性与互证性的证据图景(Kant et al., 2019)。关于多模态的融合方法大致分为模型无关的融合方法(也称显性融合方式)和基于模型的融合方法(也称隐形融合方式)两大类。

模型无关的融合方法包括早期融合、后期融合和混合融合三种。早期融合又称特征融合,是指对模态进行特征提取之后进行融合的方式;后期融合也称决策层融合,指的是在每种模态都做出决策之后才进行的融合;混合融合综合了早期融合与后期融合的优点,但也使得模型的结构变得复杂并加大了训练的难度(任泽裕、王振超、柯尊旺等,2021)。模型无关的融合方法优点是操作比较简单,但实用性较低且损失较高,难以捕捉模态之间的关联。

基于模型的融合方法包括基于张量的融合、基于注意力的融合方法和神经网络方法等,这种方法比较复杂但准确率高、适用范围广且实用性强,是目前运用的主流方法(任泽裕、王振超、柯尊旺等,2021)。其中基于注意力的融合方法是近年来被应用最广泛的融合策略,其代表模型为基于Transformer的情感识别模型,该模型可利用注意力机制来学习模态信息之间的依赖关系,由于其结构上可以实现并行化处理,因此被广泛应用于多模态数据场景下(林敏鸿和蒙祖强,2020)。

3.3. 情感识别与反馈

情感识别与反馈阶段的本质是多模态数据的处理与利用,主要任务是情感分析模型的构建与情感状态的反馈。

情感分析模型的是多模态情感分析的关键所在,直接决定了最终的分析结果。目前多模态情感分析领域比较流行的算法模型是基于注意力机制对多模态数据进行特征提取,确定模态之间的优先级于权重,实现较高精度的情感识别。如Chen等人将嵌入门控机制的 LSTM 结合注意力机制在单词级别上进行模态融合,能够识别积极、消极或中性三种情感状态(Chen et al., 2019);林敏鸿等人在TFN模型的基础上,提出了基于注意力神经网络的多模态情感分析模型,能够融合特征向量对图文信息的情绪极性(积极、消极)进行识别(林敏鸿和蒙祖强,2020);宋元丰等人基于多任务学习和注意力机制,构建了基于注意力的多层次混合融合的多任务多模态情感分析模型,考虑注意力机制实现模态融合,识别模态间的相关性和任务贡献度最高的模态,赋予不同模态贡献度权重,分析对话的情感极性(正向、负向)并赋予情绪标签(愤怒、厌恶、恐惧、快乐、悲伤、惊喜、无情绪七种)(宋云峰、任鸽、杨勇和樊小超,2022)。

情感状态的反馈阶段是将识别出的情感状态反馈给学习者和教师,实现对学习的调节与改进。教师可以预先设计干预策略和干预材料,根据情感识别结果选择合适的干预时间、干预频率和干预强度等,帮助学习者进行学习状态调整。学习者可以根据情感识别结果进行自主调节,调整时间分配、任务规划、学习策略等,实现对学习过程的自我监控与调节。

4. 多模态情感分析未来趋势

随着传感器、可穿戴设备和机器学习等技术的不断完善,多模态情感分析呈现出以下几种发展趋势:

4.1. 探索更多教育场景中的应用

目前已经有研究者在教育领域中应用多模态情感分析,但由于技术设备、教师能力、学习者隐私等各种因素的限制,目前的应用范围不够广泛。未来可以探索更多教育场景中的多模态情感分析应用,观察不同的情绪状态如何在不同的学习场景(如在线学习、面对面学习、移动学习、游戏化学习、混合式学习等)中影响学习过程和学习结果,尝试应用不同的技术来调整学习者的消极情绪状态,探索在教育环境中触发积极情绪和调整消极情绪的方法,帮助学习者调整学习状态,提高学习效率。不同的学习场景由于群体规模和场景需求不同,需要采取不同的干预策略(武法提、高姝睿和田浩,2022),对于更多教育场景中应用的探索,形成情感干预策略库,有助于针对性地结合具体教育场景提供情感反馈与干预。

4.2. 探索多模态数据的最佳组合方式

以往研究证明,大多数情况下,并不是融合的模态信息越丰富,情感分类的准确率就越高,这主要是因为不同模态的信息对于情感分类的贡献是不相等的(包广斌、李港乐和王国雄,2022)。针对不同的教育应用场景,可能存在不同的最佳模态组合方式,有可能通过不同模态数据的融合进一步提高情感预测的准确性。未来可以在不同的学习情景中进行多模态情感分析的实证探究,将不同时间尺度和不同结构的模态数据进行结合,探究不同情境下的多模态数据的最佳组合方式,为不同情境下的多模态情感数据收集提供参考和依据。

4.3. 优化情感分析模型和系统

目前许多研究人员已经在多模态情感分析模型构建和多模态情感分析系统上进行了一些探索工作,如TS等人在课堂环境下通过摄像头采集学生的面部表情、手势与身体姿态数据,利用卷积神经网络算法与特征融合策略,实现对投入、无聊和中立三种情感状态的自动识别(TS, & Guddeti,2020)。但由于多模态情感分析是一个新兴领域,许多成果还有待改进与完善。未来应进一步提高多模态情感分析的准确度,结合数据的上下文信息,考虑模态间的交互关系和模态贡献度,优化数据融合与处理方式,进一步细化输出结果,识别更多的情感类型和心理状态,提高模型的可解释度,为学习干预提供更多有价值的信息。另外,多模态情感分析系统应不断完善功能、提高性能,并与教育实践和应用相结合,增加干预策略,开发人机智能协同系统,提高系统的有效性和可用性,设计更有效、简单易用且适用范围广的情感分析系统(Yadegaridehkordi et al., 2019),实施智能化的精准学习干预。

4.4. 纳入更多情感状态

目前在情感分析领域,已经被考虑的情感状态包括无聊、愤怒、焦虑、享受、惊讶、悲伤、沮丧、骄傲、希望、绝望、羞愧、困惑、幸福、自然情绪、恐惧、喜悦、厌恶、兴趣、放松和兴奋等二十多种类别,但目前主要还是围绕情感极性(积极、消极、中立)的情感分类分析,未来应纳入更多的情感状态,使用多模态数据挖掘更多学生心理特征,更加真实地反映学习者的情感,为教师的精准干预和学生的自我调节学习提供更加细粒度的情感数据。

5. 结语

本文介绍了多模态情感分析的发展动因、实施路径、未来研究发展趋势。其中多模态情感分析的发展动因主要有外在技术推动、内在机理探索驱动和自身独特优势加持三个方面,实施路径主要包括数据采集与处理、多模态数据融合、情感识别与反馈三个主要步骤,常用的数据包括文本、音频、图像和生理数据。未来多模态情感分析的发展可以探索更多教育场景中的应用、探索多模态数据的最佳组合方式、优化情感分析模型和系统以及纳入更多情感状态。

多模态情感分析由于利用了多源数据,能够更加真实地捕捉学生的情感状态,但由于多源数据之间的时间尺度不同,且各模态数据具有互补或冗余关系,因此还有许多关键问题需要进一步解决,多模态情感分析在教育中的应用模式也需要进一步探索与归纳。但随着技术发展和算法模型的完善,多模态情感分析势必会助力学生情感状态的精准识别和有效干预。

参考文献

包广斌,李港乐 & 王国雄.(2022).面向多模态情感分析的双模态交互注意力. 计算机科学与探索(04),909-916.

韩崇昭, 朱洪艳, & 段战胜. (2010). 多源信息融合. 清华大学出版社.

李志义, 许洪凯, & 段斌. (2019). 基于深度学习cnn模型的图像情感特征抽取研究. 图书情报工作, 63(11), 12.

林敏鸿,蒙祖强. (2020). 基于注意力神经网络的多模态情感分析. 计算机科学, 47(S02), 8.

黄涛, 王一岩, 张浩, & 杨华利. (2020). 智能教育场域中的学习者建模研究趋向. 远程教育杂志, 38(1), 11.

牟智佳.(2020).多模态学习分析:学习分析研究新生长点. 电化教育研究(05),27-32+51.

任泽裕,王振超,柯尊旺,李哲 & 吾守尔·斯拉木.(2021).多模态数据融合综述. 计算机工程

与应用(18),49-64.

宋云峰,任鸽,杨勇 & 樊小超.(2022).基于注意力的多层次混合融合的多任务多模态情感分析. 计算机应用研究(03),716-720.

汤丽萍, & 陈芬. (2018). 基于情感的图像分类研究进展. 情报理论与实践, 41(6), 6.

汪维富 & 毛美娟.(2021).多模态学习分析:理解与评价真实学习的新路向. 电化教育研究(02),25-32.

武法提,高姝睿 & 田浩.(2022).人机智能协同的精准学习干预:动因、模型与路向. 电化教育研究(04),70-76.

吴永和, 李若晨, & 王浩楠. (2017). 学习分析研究的现状与未来发展——2017年学习分析与知识国际会议评析. 开放教育研究, 23(5), 15.

张琪, & 武法提. (2016). 学习分析中的生物数据表征——眼动与多模态技术应用前瞻. 电化教育研究, 037(009), 76-81,109.

周进, 叶俊民, & 李超. (2021). 多模态学习情感计算:动因,框架与建议. 电化教育研究, 42(7), 8.

周进,叶俊民,王志峰,蔡霞 & 李超.(2020).国外情感分析教育应用的进展与启示. 现代教育技术(12),34-40.

朱琳琳, & 徐健. (2017). 网络评论情感分析关键技术及应用研究. 情报理论与实践, 40(1), 7.

Chen, M., Wang, S., Liang, P. P., Baltrušaitis, T., Zadeh, A., & Morency, L. P. (2017, November). Multimodal sentiment analysis with word-level fusion and reinforcement learning. In Proceedings of the 19th ACM international conference on multimodal interaction (pp. 163-171).

D'Mello, S. , & Kory, J. . (2012). Consistent but modest: a meta-analysis on unimodal and multimodal affect detection accuracies from 30 studies.. ACM.

Giannakos, M. N., Sharma, K., Pappas, I. O., Kostakos, V., & Velloso, E. (2019). Multimodal data as a means to understand the learning experience. International Journal of Information Management, 48, 108-119.

Huddar, M. G., Sannakki, S. S., & Rajpurohit, V. S. (2019). A survey of computational approaches and challenges in multimodal sentiment analysis. Int J Comput Sci Eng, 7(1), 876-883.

Kant Shankar, S., Ruiz Calleja, A., Serrano Iglesias, S., Ortega Arranz, A., Topali, P., & Martínez Monés, A. (2019). A data value chain to model the processing of multimodal evidence in authentic learning scenarios. CEUR Workshop Proceedings.

Lane, H. C., & D’Mello, S. K. (2019). Uses of physiological monitoring in intelligent learning environments: A review of research, evidence, and technologies. Mind, brain and technology, 67-86.

Liu, B. (2012). Sentiment analysis and opinion mining. Synthesis lectures on human language technologies, 5(1), 1-167.

Olsen, J. K., Sharma, K., Rummel, N., & Aleven, V. (2020). Temporal analysis of multimodal data to predict collaborative learning outcomes. British Journal of Educational Technology, 51(5), 1527-1547.

Poria, S., Cambria, E., Bajpai, R., & Hussain, A. (2017). A review of affective computing: From unimodal analysis to multimodal fusion. Information Fusion, 37, 98-125.

Reis, R. C. D., Isotani, S., Rodriguez, C. L., Lyra, K. T., Jaques, P. A., & Bittencourt, I. I. (2018). Affective states in computer-supported collaborative learning: Studying the past to drive the future. Computers & Education, 120, 29-50.

TS, A., & Guddeti, R. M. R. (2020). Automatic detection of students’ affective states in classroom environment using hybrid convolutional neural networks. Education and Information Technologies, 25(2), 1387-1415.

Yadegaridehkordi, E., Noor, N. F. B. M., Ayub, M. N. B., Affal, H. B., & Hussin, N. B. (2019). Affective computing in education: A systematic review and future research. Computers & Education, 142, 103649.